愚人节当天,知名YouTuber小玉上传了一则影片,画面中显示高雄市长韩国瑜身穿蓝色衬衫,用夸大的言词说着无俚头的话。原来,这是小玉为了向民众唿吁假新闻的风险,而利用Deepfake技术所制造出来的假影片。该影片很快就上了热门影片排行,掀起网友热议。

Deepfake,中文译作「深假」或「深伪」,是一种透过人工智慧(AI)中的deep learning(深度学习)技术所创造出的fake(伪造)讯息。Deepfake技术可以用于影像及声音,只需要仿造对象的人物影音素材,就能制造出唯妙唯肖的假影片。

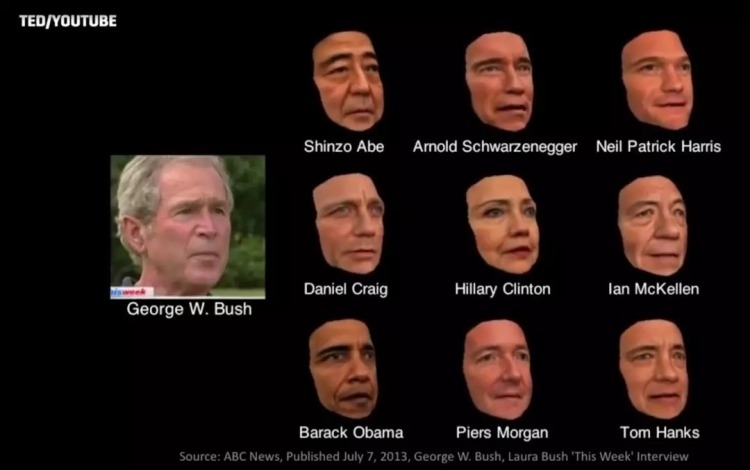

即使Deepfake在台湾尚未被广泛地应用,在西方国家却已成为国际媒体频繁讨论的焦点。美国前总统欧巴马、脸书创办人马克・祖克柏等名人的Deepfake影片近年来层出不穷,俨然成了有心人士在网路资讯战上操弄风向的关键武器——可怕的是,不是工程师也可以办得到。

小玉在影片中就表示:「(影片所使用的技术)是我花了150块人民币买下的AI换脸软体, 只要花30分钟的时间和一个配音员,我可以让韩国瑜讲出任何我想要他讲的话 。」

的确,在Github等程式码平台上,开源的Deepfake技术大幅降低应用门槛,让人轻松下载就能使用的各式换脸App,要做出一个简单的Deepfake影片并非难事。也因此,社群媒体如Facebook在今年1月祭出强硬措施,下架Deepfake影片,而Twitter也在2月时跟进。

令人担心的是,从Deepfake衍生的问题,可不光只是假讯息。

逾9成明星A片都是假的,「深伪色情」一般人更难防

一项新科技所带来的威胁,有可能会不断演变、扩及不同领域。Deepfake一词于2017年首次出现时,人们最担心的,是它在色情影片上的应用。

根据AI新创Deeptrace于去年的报告显示,截至目前,网路上仍有高达96%的Deepfake影片,是未经当事人许可下合成的色情影片。上传这些色情影片的论坛累计超过1.34亿次的浏览量,神力女超人盖儿・加朵(Gal Gadot)及黑寡妇史嘉蕾・乔韩森(Scarlett Johansson)等上百位国际女星都是受害者。

明星或许还有名气作为最后一层防护,但对一般人而言就不同了。社会新闻中,情侣分手后用「报復性色情影片」(Revenge Porn)要胁的事件屡见不鲜,但当报復性色情影片遇上Deepfake,恐怕将唤起人们心中最深层的恐惧。

2018年,一位印度的调查记者拉娜・艾雅伯(Rana Ayyub)在揭露了一则关于克什米尔女孩性侵事件的两天后,于Whatsapp上看到社群在疯传以她为主角的Deepfake色情影片。她的社群平台被不雅影片的截图给洗版,而她却不知道如何向别人说明,影片中的人并不是她。

加拿大起家的新媒体Vice就曾派旗下记者实际到网路上找人客制化Deepfake色情影片,结果只花了约900块新台币就得到了成品,显示Deepfake的产制已长出了基础的商业模式。

这就是Deepfake恐怖之处,只要找到门路,任何人都能用极高说服力,将你没有说过的话、没有做过的事给强压在你身上。不过,既然Deepfake是以AI作为武器,以其人之道还治其人之身,「AI攻防战」似乎是最主要的解套方式。

来自AI的黑暗威胁,假讯息攻防战没人能倖免

以查破社群平台假帐号起家的以色列新创Cyabra,近来就成功研发侦破Deepfake的AI技术,并以该技术在今年2月的美台科技挑战赛中获得亚军。Cyabra全球业务副总裁阿赛夫・丹比(Assaf Danby)表示,透过他们所开发的AI演算法揪出Deepfake影片,准确率可达97%。

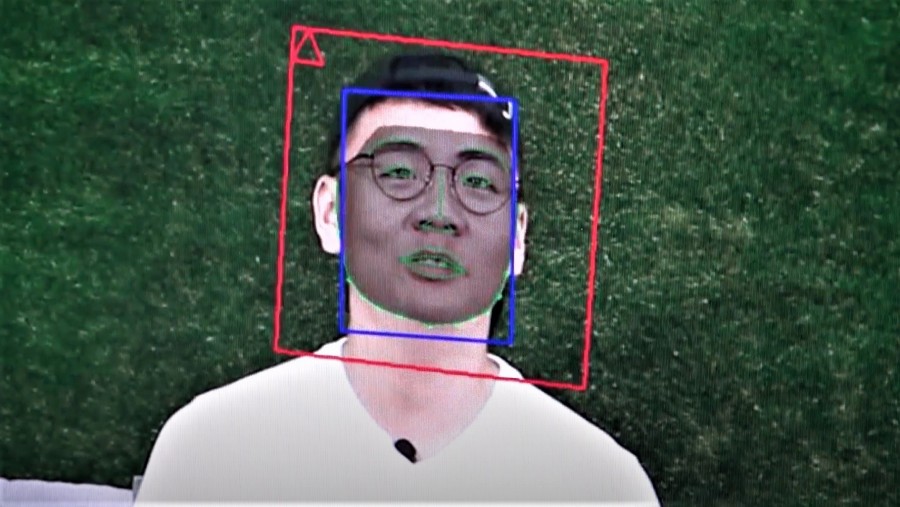

他们是怎么做到的?他们研究影片的解析度及压缩率等数值,并拿来分析人物脸部表情及肢体动作是否自然。

好比说,戴上眼镜后人脸焦距的变化是否正确?嘴唇的动作与下巴及喉结肌肉的连动状况有无异状?「我们能够一帧一帧的检验影片的真伪。」丹比说。

Cyabra今年的任务,本是与美国国务院合作,为2020年美国总统大选防堵假资讯。但自从新冠状病毒(COVID-19,俗称武汉肺炎)疫情爆发以来,查核疫情不实资讯就成了他们的主要目标。「3月底时我们就发现,有一个以国际药厂Roche(罗氏)为名的影片,声称他们做出了疫苗。」

从色情影片威胁、到各种议题的资讯操作,随着Deepfake技术日新月异,涉及的犯罪领域也不断扩大。丹比唿吁,下一波Deepfake攻击,可能将锁定网路银行的用户。「愈来愈多用户选择透过视讯电话来开户,而Deepfake影片也能伪造某人身分,在视讯电话中通过银行的人脸辨识系统审查。」

说到底,技术毕竟是中性的。对丹比来说,AI是世界正式踏入「人类世」的证据。「这项技术将继续改变人类的生活——无论是好是坏,」他说,「或许人类世所代表的,就是我们在好坏之间拉锯,与AI共舞的时代。」

在这些真假难辨的资讯中,唯有一件事情是肯定的,那便是人们对于「真相」的理解将重新被形塑。

责任编辑:林美欣

导演李安的新片《双子杀手》,讲述了一个由威尔・史密斯(Will Smith)扮演的中年退休特务,遭到有着自己年轻时期样貌的复制人所追杀的故事。有趣的是,这个复制人并非替身所饰演,而是由电影特效(CGI)制作而成。

曾获奥斯卡奖的电影特效公司DNEG创办人保罗・富兰克林(Paul Franklin)说,在高端视觉特效领域里,要做出能呈现在电影上的拟真人像,每分钟的成本可高达数百万美元。但他也发现,过去几年来,许多由特效公司提供的服务,都已出现在普通民众智慧型手机里的App了。

「双子杀手中用到的技术,在接下来的10年内,必然会变得唾手可得。」富兰克林表示。而作为视觉特效的一种应用,近年来逐渐普及化的Deepfake,很快地将成为人们手指滑一滑就能使用的技术。

Deepfake生成机制1:自动编码器(Autoencoder)

这项看似神奇的换脸招数,究竟是怎么做出来的呢?

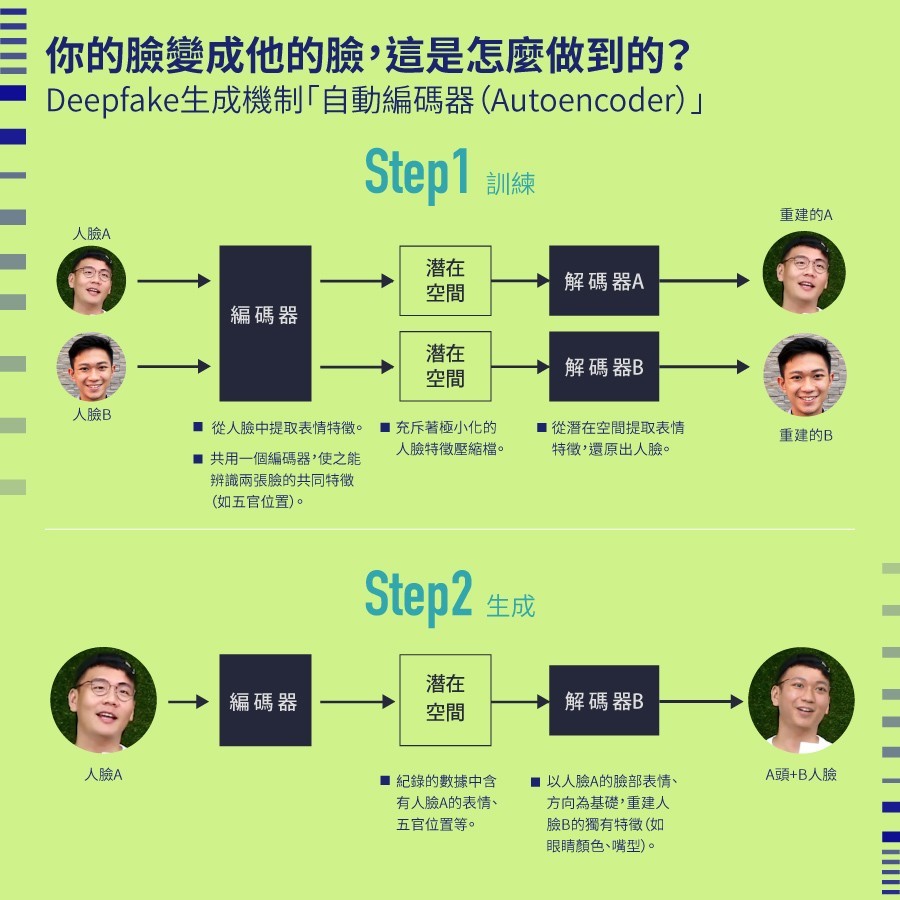

Deepfake的生成一般会有两种方法。一个叫做自动编码器(AutoEncoder),另一个叫做生成对抗网路(Generative Adversarial Network, GAN),两者都是AI深度学习的应用方式。

在自动编码器中,你会将人脸A与人脸B,各自准备上百张以后,丢进一组叫「编码器」的AI模型内。编码器会搜集两张脸相似的地方,并把它们压缩成极小的数据。

这时,会有叫做「解码器」的两组不同AI模型,分别读取这些极小的数据,重建出人脸A及人脸B。经过成百上千回的训练,编码器与解码器会自行学习调整,重建出更精确的人脸。

训练完后,就到了换脸的阶段。这时只要故意将输入的人脸用「错误」的解码器重建,就能达成目的。

举例来说,将压缩后的人脸A用人脸B的解码器重建时,由于压缩时用的是同一个编码器,两张脸的共同特徵如五官位置的定位等资讯,会特别被强调。这样一来,解码器B就会利用人脸A的表情与五官定位,进行人脸B的重建,等于让A的头长出B的脸。

Deepfake 生成机制2:生成对抗网路(GAN)

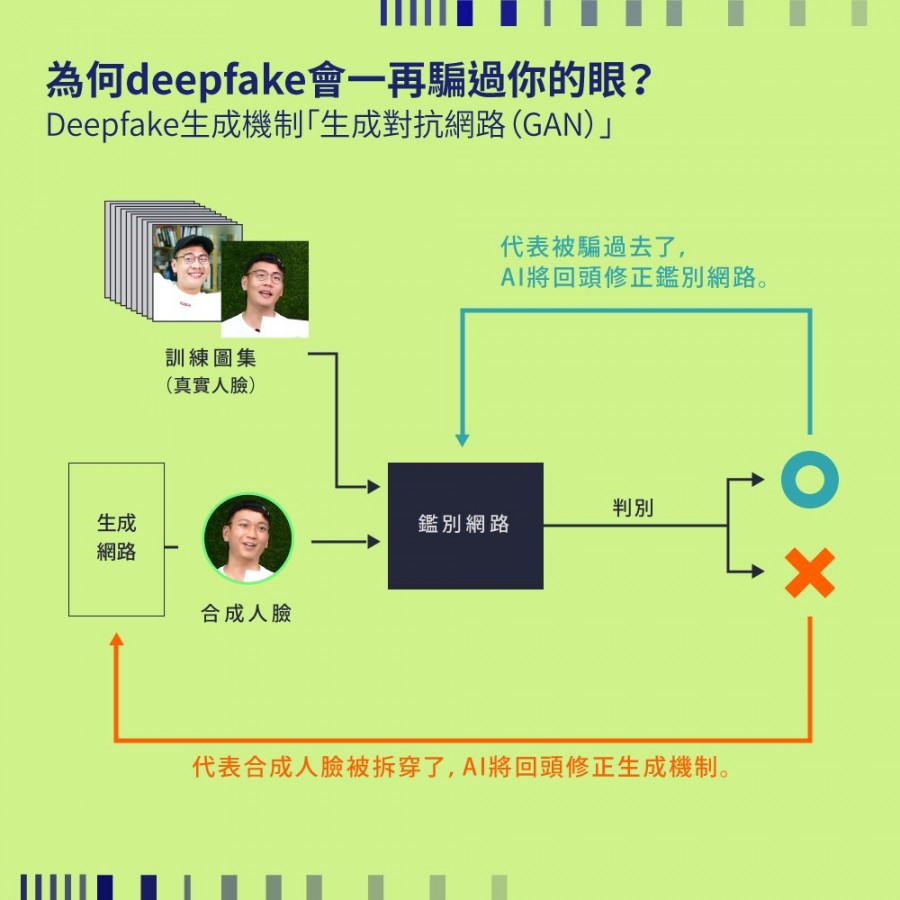

另一种近年来相当热门的方法GAN,则是由「生成网路」及「鑑别网路」两组AI模型组成。GAN的运作方式,主要是透过这两组模型相互拮抗、回馈,经过多轮训练后,产出的图片更为精准。

简单比喻,生成网路就是一个赝品仿画的大师,鑑别网路则顾名思义,是个鑑定家。仿画大师要想办法骗过鑑定家,鑑定家则要想办法拆穿仿画大师。仿画大师会基由低维度的数据来合成图片,而这张「假图」则会交给鑑定家,由他来决定其真伪。

利用每一轮测验提供的反馈,仿画大师和鑑定家皆能进步,在下一轮产出更真实的合成图片。

用户抢当电影主角,「移植人脸」应用商机无限

原理有些复杂,但大家用不着担心。

台湾虚实展演发展协会的互动设计师游俊彦表示,网路上的开源平台,有许多Deepfake的程式码套件,而网友也循此推出了套装软体。只要桌机规格有达Intel i7四核心、配载GTX 970以上的显示卡,等于一般绘图设计师或游戏玩家所需的配置,AI运算就跑得动。

游俊彦表示,透过FakeApp、DeepFaceLab等现成软体与网路上的教学,要制作一个自己的Deepfake 影片,称不上一件难事。「你只要用Full HD的解析度,捕捉目标素材人脸的各种角度、表情与嘴型,下载软体后,前置作业就完成了,」他说,「FakeApp甚至还有UI(使用者介面)介面,方便用户操作。」

至于是否有更方便使用的App?2019年9月,中国曾推出了一款换脸App「ZAO」,用户可以把自身面孔加叠到名人脸上,后来却因为隐私授权疑虑,在上线3天后匆匆下架。但那短短3天内,ZAO直接登上Apple商店排行榜第一名,为了让自己能取代热门影集或电影里的主角,用户们纷纷上传自拍照,引发热烈讨论。

ZAO虽然下架了,但「换脸」的商机,App开发商都看在眼底了。若相关法规的制定能让隐私权有进一步的保障,那么架上出现另一款Deepfake App,或许指日可待。

责任编辑:林美欣

从新型态网路诈骗到形塑社会矛盾,Deepfake技术出现至今3年间,对「信任」一词的伤害力,恐怕比想像中还要巨大。

2019年3月,国际间出现了前所未见的网路诈骗行为。一位英国能源公司CEO接到他德国母公司老闆的电话,要求他代垫约730万新台币款项,将费用转给该集团位于匈牙利的一家供应商,并表示之后会再将钱补还给他。

然而,这位CEO不但没领到钱,反而又一次接到老闆电话,指定他支付另一笔款项。这时他才惊觉,即便老闆德国口音听上去很正常,实际上却是由Deepfake模拟出来的人声。那笔730万元的款项,也从匈牙利被转到墨西哥,再匯往多个不同地区,难以追查下落。

资安大厂趋势科技机器学习研究员张佳彦表示,这是一种进阶版「变脸诈骗」(Business Email Compromise,又称商业电邮诈骗)。他说,随着Deepfake技术门槛降低,过去在商业邮件中模仿他人文字风格为主的诈骗行为,开始走向影像与声音应用,彰显了Deepfake逐渐扩张的威胁性。

打假办法才被提出,一下子就被「突破」

「一旦Deepfake制造时间能压缩到数分钟内,Deepfake诈骗就可能愈来愈常见。」张佳彦说。

张佳彦表示,要做出比较拟真的Deepfake,以现有技术来说,影片会需要约数百到数千张人脸素材照片、声音则需要约20分钟录音档,并让深度学习的模型演算约一个礼拜时间才可行,时间、技术成本较高。但他也认为,未来Deepfake诈骗的发展性,恐怕难以估量。

令人稍微庆幸的,趋势科技目前尚未在台湾发现Deepfake网路诈骗行为。「相较于传统网路钓鱼攻击一次就可以发上万则电子邮件,用Deepfake做变脸诈骗技术成本还是比较高。」张佳彦说。

值得注意的是,近年来Deepfake的进展速度,正不断超越现有检测技术。

2018年时,纽约州立大学奥尔巴尼分校电脑科学系副教授吕思伟曾提交一篇论文,点出Deepfake影片中人物眨眼频率过低,便建议以此作为检测标准。

原来,他发现许多名人Deepfake影音的训练素材,都来自于公开照片,鲜少有闭眼的图像数据,导致眨眼动作显得不流畅。然而,在这则论文公开以后,Deepfake制造者很快就更新了他们的AI训练模型,克服了眨眼问题。「这是一个持续战斗的过程。」吕思伟表示。

就现阶段而言,若想防止自身相关影片被有心之人拿来做Deepfake,张佳彦提出一个建议:「你可以试着在影片中用手晃过自己脸上,」他说,「东西晃过去时会切割脸部画面,就现阶段技术而言,很难没有破绽。」

然而,谁也不知道,这招防御方法,是否哪天会被持续进步的技术破解。

Deepfake威胁,除了金钱损失以外,透过假资讯造成的意见分歧,也可能造成社会剧烈影响。在中非国家加彭(Gabon),甚至成为一起政变导火线。

总统拜年影片是Deepfake?被不信任催化的一场政变

2019年1月7日,一群武装军人占领了加彭国家广播电台,指责现任总统邦戈(Ali Bongo)已无能力继续领导国家,要发动政变。究竟这个近年来政局相对稳定的非洲重要石油生产国,为何会遭遇政变?《纽约时报》指出,Deepfake是一大关键因素。

时间往前至2018年10月底,邦戈在拜访沙乌地阿拉伯时惊传就医,此后3个月内,除了一些官方照片以外,加彭当局鲜少释出其他讯息。人民强烈的焦虑感,点燃了阴谋论的火种,各种流言四起。直到2019年新年除夕,邦戈亲自出现在电视上向人民拜年,但萤幕上的他看似中风的模样,却引发大众揣测。

有反对党成员跳出来,指责这是一支Deepfake影片;也有人怀疑,邦戈健康状态已严重到不能露面,而实际掌权的,是他身旁贪腐的裙带集团。影片播出后第7天,武装集团便展开政变行动。

后来,政变在数小时内遭当局平定,邦戈也在同年3月底康復返回加彭。吕思伟后来检验了该影片,认定其「极可能」并非Deepfake——但造谣容易,澄清却很困难。这起事件也证实了假资讯操弄手段,加上早已动乱的舆论氛围,对社会影响相当深远。

假资讯造成的纷乱,在世界各地都有了先例。今年是美国大选年,也是Deepfake一词在2017年诞生后,首次遭遇美国总统大选。为了防堵Deepfake恶意操弄,社群平台如Facebook也在2020年1月宣布,除了刻意用来嘲讽的影片以外,他们会下架所有Deepfake影片。

此外,Facebook也与其他科技大厂如微软、AWS(亚马逊网路服务)联手,发起Deepfake侦测挑战赛,投入100万美元总奖金来激励侦测技术研发,希望破解更多层出不穷的Deepfake手法。

然而,无论社群平台对抗操弄资讯者,或是资安公司对抗网路诈欺犯,两者最终都指向一场不断升级的AI军备竞赛。站在这个看不到尽头的竞赛起跑点,我们将要奔向的未来,或许正是一个「眼见不能为凭」的时代。

责任编辑:林美欣

在新冠状病毒(COVID-19,俗称武汉肺炎)疫情肆虐下,2012年出版的知名游戏《瘟疫公司》彷彿成了人们生活的写照。这款让玩家操作病毒,目的是要扩散全球,让人类毁灭的游戏,至今已吸引了1.3亿人下载。人们说,《瘟疫公司》是先知,预测了人类的未来。

许多人可能不知道的是,这款游戏预测的,恐怕不只是病毒的侵袭。《瘟疫公司》内有一个副本,让玩家散布假新闻,目的是要骗过全世界。而Deepfake,或许正是让假新闻和病毒一样,神不知鬼不觉扩散的那项关键技术。

深伪AI蓬勃发展,连科学专家都徬徨不安

Deepfake将使人们愈来愈难辨明真相,但究竟Deepfake的技术还要多久会真正成熟?根据南加州大学资讯工程副教授黎灏(Hao Li)的说法, 恐怕再过半年,Deepfake技术就会开始普及化 。

黎灏原先预测,Deepfake技术成熟化尚需2到3年。但过去一年来,科技大厂积极布局相关技术,在中国,换脸App「ZAO」出现,让人们可以轻松应用Deepfake;在美国,社群巨头Snap也在今年1月砸下近50亿新台币,买下研究脸部侦测技术的新创公司AI Factory,藉以优化其类似于Deepfake的应用服务,这些都加速了Deepfake的发展。

他同时悲观地预测,侦测Deepfake的AI技术将会输给产制Deepfake的AI技术,人们必须找其他的方法来应付由Deepfake驱动的资讯战。

值得注意的是,就在今年2月底,AI电脑视觉领域的权威、知名影像辨识演算法「YOLO」的开发者乔瑟夫・瑞德曼(Joseph Redmon)也宣布,自己将中止一切关于电脑视觉的研究,在AI圈造成不小的轰动。

瑞德曼说,他虽热爱自己的研究,但他同时也对这些研究成果将会如何被拿来应用、以及后续延伸的道德议题感到不安。这似乎也暗示了,影像辨识、侦测甚至重建的AI深度学习模型的成熟度,已经使专家学者都无法忽视。

但一个权威退下阵来,不代表其他学者不会迎头赶上。

既然AI技术的高速发展是阻挡不来的大势,那它会对未来社会造成什么影响?北科大互动设计系助理教授葛如钧预测,在未来,每个人的脸跟声音,都会成为相当重要的资产。

「我觉得人们会迎来一个真相非常宝贵的时代,」葛如钧说,「因为别人可以很低的门槛,利用他人的脸和声音做不好的事情。像是用在色情影片里、被拿去开银行帐户,或者用来诈骗都有可能。」

与真相的距离被拉大,人们要如何适应?

面对自己的脸与声音被盗用的风险,葛如钧认为,未来可能会出现一种平台,专门让人公开註册自己的脸部数据。想要使用的,就经过合法授权程序来申请,否则就会开罚。透过类似版权的概念,藉以防堵未来「盗版人脸」猖獗的问题。

但他也表示,这样的应用也可能发展出自己的一套商业模式。举例来说,某些艺人或者网红,可能只要授权自己的脸,就可以透过一个身形相似的替身,来帮他们出外景、主持节目。

听起来令人难以接受吗?葛如钧指出,我们生活中本来就已经有「无修正的真相」以及「修正过的真相」之分。至少目前可以看到,大家对直播主用化妆及滤镜效果做出的样貌开始觉得稀松平常,逐渐接受这样的「修正过的真相」。

而人们对「遭到微调、修正的真相」的接受程度,恐怕只会愈来愈宽。

Deepfake的技术成熟,对社会也不只有坏处。除了能够优化VR里的3D人物建模等,科技领域的推进与成长;在具体应用方面,近来就有印度政党在一次选前影片中,利用Deepfake技术让参选人用不同的方言说话。对于有超过20种官方语言的印度来说,可说是大大地帮候选人拉近了与选民的距离。

Deepfake并非洪水勐兽。但它的到来,势必会拉高人们得到真相所需的门槛。

「你看网路上的Deepfake影片,下面总有许多网友留言说:『你做得太烂了,一看就知道是假的!』这其实是很危险的徵兆。」葛如钧说。

「大家太相信自己的判断力了。要能真的不上Deepfake的当,每个人都应该自带一个防御机制——也就是相信你自己绝对看不出真假,才有办法抵御。」

责任编辑:林美欣

出处:https://www.bnext.com.tw/article/57308/deepfake-autoencoder-gan