愚人節當天,知名YouTuber小玉上傳了一則影片,畫面中顯示高雄市長韓國瑜身穿藍色襯衫,用誇大的言詞說著無俚頭的話。原來,這是小玉為了向民眾呼籲假新聞的風險,而利用Deepfake技術所製造出來的假影片。該影片很快就上了熱門影片排行,掀起網友熱議。

Deepfake,中文譯作「深假」或「深偽」,是一種透過人工智慧(AI)中的deep learning(深度學習)技術所創造出的fake(偽造)訊息。Deepfake技術可以用於影像及聲音,只需要仿造對象的人物影音素材,就能製造出唯妙唯肖的假影片。

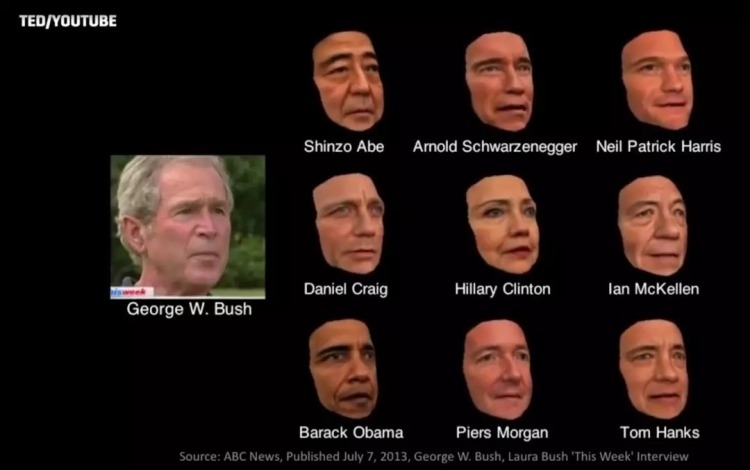

即使Deepfake在台灣尚未被廣泛地應用,在西方國家卻已成為國際媒體頻繁討論的焦點。美國前總統歐巴馬、臉書創辦人馬克・祖克柏等名人的Deepfake影片近年來層出不窮,儼然成了有心人士在網路資訊戰上操弄風向的關鍵武器——可怕的是,不是工程師也可以辦得到。

小玉在影片中就表示:「(影片所使用的技術)是我花了150塊人民幣買下的AI換臉軟體, 只要花30分鐘的時間和一個配音員,我可以讓韓國瑜講出任何我想要他講的話 。」

的確,在Github等程式碼平台上,開源的Deepfake技術大幅降低應用門檻,讓人輕鬆下載就能使用的各式換臉App,要做出一個簡單的Deepfake影片並非難事。也因此,社群媒體如Facebook在今年1月祭出強硬措施,下架Deepfake影片,而Twitter也在2月時跟進。

令人擔心的是,從Deepfake衍生的問題,可不光只是假訊息。

逾9成明星A片都是假的,「深偽色情」一般人更難防

一項新科技所帶來的威脅,有可能會不斷演變、擴及不同領域。Deepfake一詞於2017年首次出現時,人們最擔心的,是它在色情影片上的應用。

根據AI新創Deeptrace於去年的報告顯示,截至目前,網路上仍有高達96%的Deepfake影片,是未經當事人許可下合成的色情影片。上傳這些色情影片的論壇累計超過1.34億次的瀏覽量,神力女超人蓋兒・加朵(Gal Gadot)及黑寡婦史嘉蕾・喬韓森(Scarlett Johansson)等上百位國際女星都是受害者。

明星或許還有名氣作為最後一層防護,但對一般人而言就不同了。社會新聞中,情侶分手後用「報復性色情影片」(Revenge Porn)要脅的事件屢見不鮮,但當報復性色情影片遇上Deepfake,恐怕將喚起人們心中最深層的恐懼。

2018年,一位印度的調查記者拉娜・艾雅伯(Rana Ayyub)在揭露了一則關於克什米爾女孩性侵事件的兩天後,於Whatsapp上看到社群在瘋傳以她為主角的Deepfake色情影片。她的社群平台被不雅影片的截圖給洗版,而她卻不知道如何向別人說明,影片中的人並不是她。

加拿大起家的新媒體Vice就曾派旗下記者實際到網路上找人客製化Deepfake色情影片,結果只花了約900塊新台幣就得到了成品,顯示Deepfake的產製已長出了基礎的商業模式。

這就是Deepfake恐怖之處,只要找到門路,任何人都能用極高說服力,將你沒有說過的話、沒有做過的事給強壓在你身上。不過,既然Deepfake是以AI作為武器,以其人之道還治其人之身,「AI攻防戰」似乎是最主要的解套方式。

來自AI的黑暗威脅,假訊息攻防戰沒人能倖免

以查破社群平台假帳號起家的以色列新創Cyabra,近來就成功研發偵破Deepfake的AI技術,並以該技術在今年2月的美台科技挑戰賽中獲得亞軍。Cyabra全球業務副總裁阿賽夫・丹比(Assaf Danby)表示,透過他們所開發的AI演算法揪出Deepfake影片,準確率可達97%。

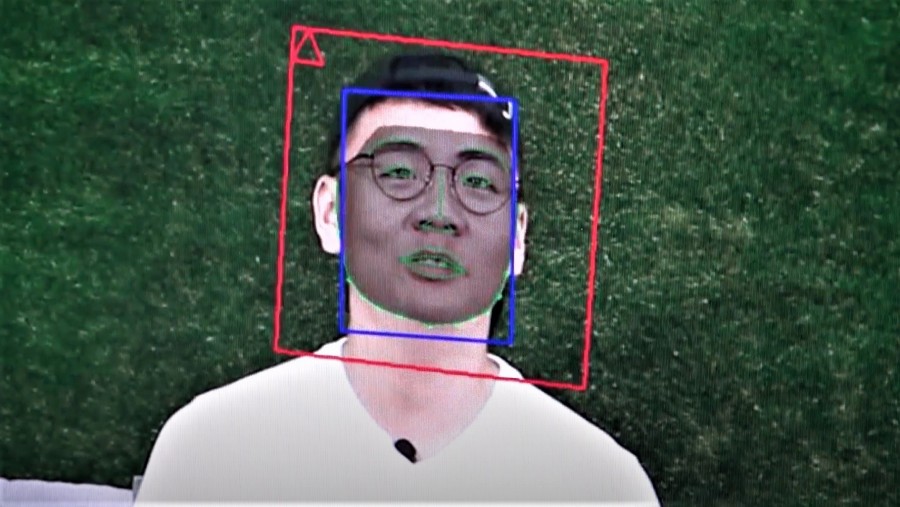

他們是怎麼做到的?他們研究影片的解析度及壓縮率等數值,並拿來分析人物臉部表情及肢體動作是否自然。

好比說,戴上眼鏡後人臉焦距的變化是否正確?嘴唇的動作與下巴及喉結肌肉的連動狀況有無異狀?「我們能夠一幀一幀的檢驗影片的真偽。」丹比說。

Cyabra今年的任務,本是與美國國務院合作,為2020年美國總統大選防堵假資訊。但自從新冠狀病毒(COVID-19,俗稱武漢肺炎)疫情爆發以來,查核疫情不實資訊就成了他們的主要目標。「3月底時我們就發現,有一個以國際藥廠Roche(羅氏)為名的影片,聲稱他們做出了疫苗。」

從色情影片威脅、到各種議題的資訊操作,隨著Deepfake技術日新月異,涉及的犯罪領域也不斷擴大。丹比呼籲,下一波Deepfake攻擊,可能將鎖定網路銀行的用戶。「愈來愈多用戶選擇透過視訊電話來開戶,而Deepfake影片也能偽造某人身分,在視訊電話中通過銀行的人臉辨識系統審查。」

說到底,技術畢竟是中性的。對丹比來說,AI是世界正式踏入「人類世」的證據。「這項技術將繼續改變人類的生活——無論是好是壞,」他說,「或許人類世所代表的,就是我們在好壞之間拉鋸,與AI共舞的時代。」

在這些真假難辨的資訊中,唯有一件事情是肯定的,那便是人們對於「真相」的理解將重新被形塑。

責任編輯:林美欣

導演李安的新片《雙子殺手》,講述了一個由威爾・史密斯(Will Smith)扮演的中年退休特務,遭到有著自己年輕時期樣貌的複製人所追殺的故事。有趣的是,這個複製人並非替身所飾演,而是由電影特效(CGI)製作而成。

曾獲奧斯卡獎的電影特效公司DNEG創辦人保羅・富蘭克林(Paul Franklin)說,在高端視覺特效領域裡,要做出能呈現在電影上的擬真人像,每分鐘的成本可高達數百萬美元。但他也發現,過去幾年來,許多由特效公司提供的服務,都已出現在普通民眾智慧型手機裡的App了。

「雙子殺手中用到的技術,在接下來的10年內,必然會變得唾手可得。」富蘭克林表示。而作為視覺特效的一種應用,近年來逐漸普及化的Deepfake,很快地將成為人們手指滑一滑就能使用的技術。

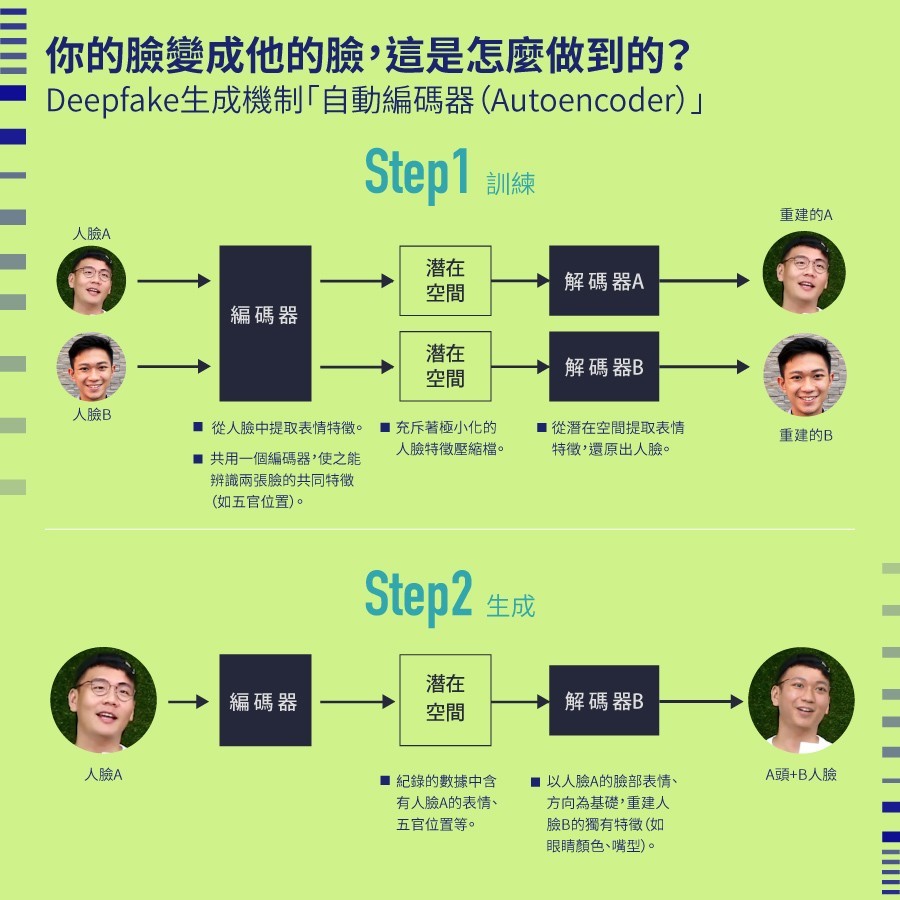

Deepfake生成機制1:自動編碼器(Autoencoder)

這項看似神奇的換臉招數,究竟是怎麼做出來的呢?

Deepfake的生成一般會有兩種方法。一個叫做自動編碼器(AutoEncoder),另一個叫做生成對抗網路(Generative Adversarial Network, GAN),兩者都是AI深度學習的應用方式。

在自動編碼器中,你會將人臉A與人臉B,各自準備上百張以後,丟進一組叫「編碼器」的AI模型內。編碼器會搜集兩張臉相似的地方,並把它們壓縮成極小的數據。

這時,會有叫做「解碼器」的兩組不同AI模型,分別讀取這些極小的數據,重建出人臉A及人臉B。經過成百上千回的訓練,編碼器與解碼器會自行學習調整,重建出更精確的人臉。

訓練完後,就到了換臉的階段。這時只要故意將輸入的人臉用「錯誤」的解碼器重建,就能達成目的。

舉例來說,將壓縮後的人臉A用人臉B的解碼器重建時,由於壓縮時用的是同一個編碼器,兩張臉的共同特徵如五官位置的定位等資訊,會特別被強調。這樣一來,解碼器B就會利用人臉A的表情與五官定位,進行人臉B的重建,等於讓A的頭長出B的臉。

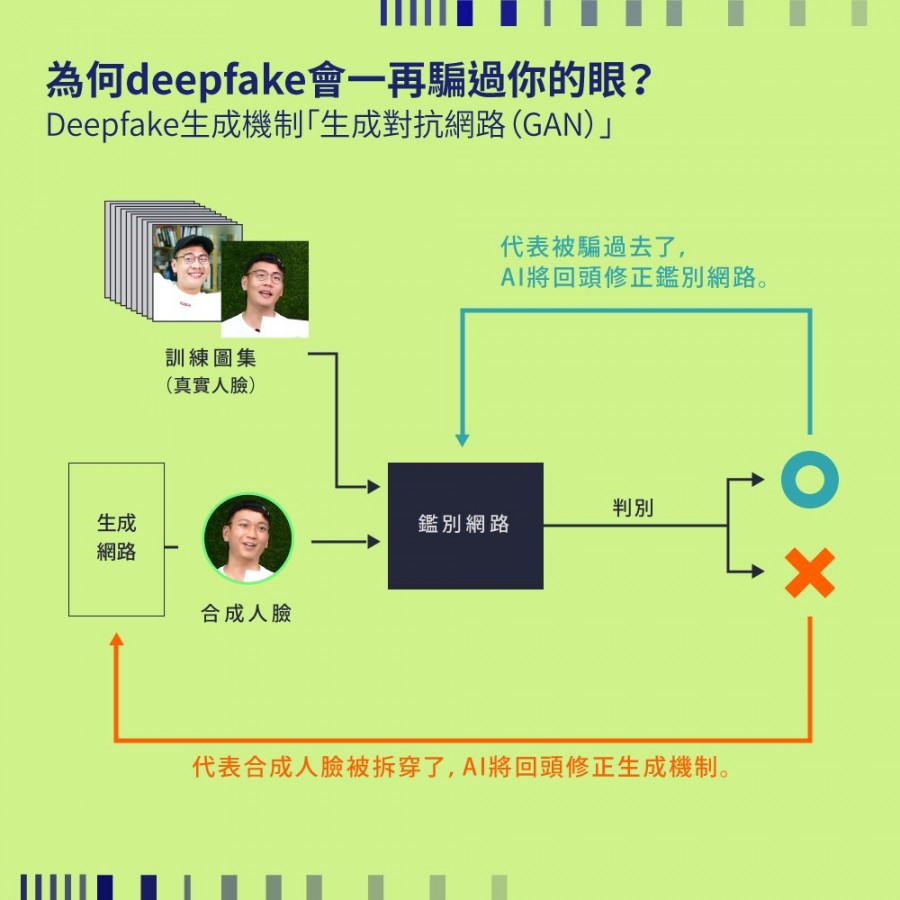

Deepfake 生成機制2:生成對抗網路(GAN)

另一種近年來相當熱門的方法GAN,則是由「生成網路」及「鑑別網路」兩組AI模型組成。GAN的運作方式,主要是透過這兩組模型相互拮抗、回饋,經過多輪訓練後,產出的圖片更為精準。

簡單比喻,生成網路就是一個贗品仿畫的大師,鑑別網路則顧名思義,是個鑑定家。仿畫大師要想辦法騙過鑑定家,鑑定家則要想辦法拆穿仿畫大師。仿畫大師會基由低維度的數據來合成圖片,而這張「假圖」則會交給鑑定家,由他來決定其真偽。

利用每一輪測驗提供的反饋,仿畫大師和鑑定家皆能進步,在下一輪產出更真實的合成圖片。

用戶搶當電影主角,「移植人臉」應用商機無限

原理有些複雜,但大家用不著擔心。

台灣虛實展演發展協會的互動設計師游俊彥表示,網路上的開源平台,有許多Deepfake的程式碼套件,而網友也循此推出了套裝軟體。只要桌機規格有達Intel i7四核心、配載GTX 970以上的顯示卡,等於一般繪圖設計師或遊戲玩家所需的配置,AI運算就跑得動。

游俊彥表示,透過FakeApp、DeepFaceLab等現成軟體與網路上的教學,要製作一個自己的Deepfake 影片,稱不上一件難事。「你只要用Full HD的解析度,捕捉目標素材人臉的各種角度、表情與嘴型,下載軟體後,前置作業就完成了,」他說,「FakeApp甚至還有UI(使用者介面)介面,方便用戶操作。」

至於是否有更方便使用的App?2019年9月,中國曾推出了一款換臉App「ZAO」,用戶可以把自身面孔加疊到名人臉上,後來卻因為隱私授權疑慮,在上線3天後匆匆下架。但那短短3天內,ZAO直接登上Apple商店排行榜第一名,為了讓自己能取代熱門影集或電影裡的主角,用戶們紛紛上傳自拍照,引發熱烈討論。

ZAO雖然下架了,但「換臉」的商機,App開發商都看在眼底了。若相關法規的制定能讓隱私權有進一步的保障,那麼架上出現另一款Deepfake App,或許指日可待。

責任編輯:林美欣

從新型態網路詐騙到形塑社會矛盾,Deepfake技術出現至今3年間,對「信任」一詞的傷害力,恐怕比想像中還要巨大。

2019年3月,國際間出現了前所未見的網路詐騙行為。一位英國能源公司CEO接到他德國母公司老闆的電話,要求他代墊約730萬新台幣款項,將費用轉給該集團位於匈牙利的一家供應商,並表示之後會再將錢補還給他。

然而,這位CEO不但沒領到錢,反而又一次接到老闆電話,指定他支付另一筆款項。這時他才驚覺,即便老闆德國口音聽上去很正常,實際上卻是由Deepfake模擬出來的人聲。那筆730萬元的款項,也從匈牙利被轉到墨西哥,再匯往多個不同地區,難以追查下落。

資安大廠趨勢科技機器學習研究員張佳彥表示,這是一種進階版「變臉詐騙」(Business Email Compromise,又稱商業電郵詐騙)。他說,隨著Deepfake技術門檻降低,過去在商業郵件中模仿他人文字風格為主的詐騙行為,開始走向影像與聲音應用,彰顯了Deepfake逐漸擴張的威脅性。

打假辦法才被提出,一下子就被「突破」

「一旦Deepfake製造時間能壓縮到數分鐘內,Deepfake詐騙就可能愈來愈常見。」張佳彥說。

張佳彥表示,要做出比較擬真的Deepfake,以現有技術來說,影片會需要約數百到數千張人臉素材照片、聲音則需要約20分鐘錄音檔,並讓深度學習的模型演算約一個禮拜時間才可行,時間、技術成本較高。但他也認為,未來Deepfake詐騙的發展性,恐怕難以估量。

令人稍微慶幸的,趨勢科技目前尚未在台灣發現Deepfake網路詐騙行為。「相較於傳統網路釣魚攻擊一次就可以發上萬則電子郵件,用Deepfake做變臉詐騙技術成本還是比較高。」張佳彥說。

值得注意的是,近年來Deepfake的進展速度,正不斷超越現有檢測技術。

2018年時,紐約州立大學奧爾巴尼分校電腦科學系副教授呂思偉曾提交一篇論文,點出Deepfake影片中人物眨眼頻率過低,便建議以此作為檢測標準。

原來,他發現許多名人Deepfake影音的訓練素材,都來自於公開照片,鮮少有閉眼的圖像數據,導致眨眼動作顯得不流暢。然而,在這則論文公開以後,Deepfake製造者很快就更新了他們的AI訓練模型,克服了眨眼問題。「這是一個持續戰鬥的過程。」呂思偉表示。

就現階段而言,若想防止自身相關影片被有心之人拿來做Deepfake,張佳彥提出一個建議:「你可以試著在影片中用手晃過自己臉上,」他說,「東西晃過去時會切割臉部畫面,就現階段技術而言,很難沒有破綻。」

然而,誰也不知道,這招防禦方法,是否哪天會被持續進步的技術破解。

Deepfake威脅,除了金錢損失以外,透過假資訊造成的意見分歧,也可能造成社會劇烈影響。在中非國家加彭(Gabon),甚至成為一起政變導火線。

總統拜年影片是Deepfake?被不信任催化的一場政變

2019年1月7日,一群武裝軍人占領了加彭國家廣播電台,指責現任總統邦戈(Ali Bongo)已無能力繼續領導國家,要發動政變。究竟這個近年來政局相對穩定的非洲重要石油生產國,為何會遭遇政變?《紐約時報》指出,Deepfake是一大關鍵因素。

時間往前至2018年10月底,邦戈在拜訪沙烏地阿拉伯時驚傳就醫,此後3個月內,除了一些官方照片以外,加彭當局鮮少釋出其他訊息。人民強烈的焦慮感,點燃了陰謀論的火種,各種流言四起。直到2019年新年除夕,邦戈親自出現在電視上向人民拜年,但螢幕上的他看似中風的模樣,卻引發大眾揣測。

有反對黨成員跳出來,指責這是一支Deepfake影片;也有人懷疑,邦戈健康狀態已嚴重到不能露面,而實際掌權的,是他身旁貪腐的裙帶集團。影片播出後第7天,武裝集團便展開政變行動。

後來,政變在數小時內遭當局平定,邦戈也在同年3月底康復返回加彭。呂思偉後來檢驗了該影片,認定其「極可能」並非Deepfake——但造謠容易,澄清卻很困難。這起事件也證實了假資訊操弄手段,加上早已動亂的輿論氛圍,對社會影響相當深遠。

假資訊造成的紛亂,在世界各地都有了先例。今年是美國大選年,也是Deepfake一詞在2017年誕生後,首次遭遇美國總統大選。為了防堵Deepfake惡意操弄,社群平台如Facebook也在2020年1月宣布,除了刻意用來嘲諷的影片以外,他們會下架所有Deepfake影片。

此外,Facebook也與其他科技大廠如微軟、AWS(亞馬遜網路服務)聯手,發起Deepfake偵測挑戰賽,投入100萬美元總獎金來激勵偵測技術研發,希望破解更多層出不窮的Deepfake手法。

然而,無論社群平台對抗操弄資訊者,或是資安公司對抗網路詐欺犯,兩者最終都指向一場不斷升級的AI軍備競賽。站在這個看不到盡頭的競賽起跑點,我們將要奔向的未來,或許正是一個「眼見不能為憑」的時代。

責任編輯:林美欣

在新冠狀病毒(COVID-19,俗稱武漢肺炎)疫情肆虐下,2012年出版的知名遊戲《瘟疫公司》彷彿成了人們生活的寫照。這款讓玩家操作病毒,目的是要擴散全球,讓人類毀滅的遊戲,至今已吸引了1.3億人下載。人們說,《瘟疫公司》是先知,預測了人類的未來。

許多人可能不知道的是,這款遊戲預測的,恐怕不只是病毒的侵襲。《瘟疫公司》內有一個副本,讓玩家散布假新聞,目的是要騙過全世界。而Deepfake,或許正是讓假新聞和病毒一樣,神不知鬼不覺擴散的那項關鍵技術。

深偽AI蓬勃發展,連科學專家都徬徨不安

Deepfake將使人們愈來愈難辨明真相,但究竟Deepfake的技術還要多久會真正成熟?根據南加州大學資訊工程副教授黎灝(Hao Li)的說法, 恐怕再過半年,Deepfake技術就會開始普及化 。

黎灝原先預測,Deepfake技術成熟化尚需2到3年。但過去一年來,科技大廠積極布局相關技術,在中國,換臉App「ZAO」出現,讓人們可以輕鬆應用Deepfake;在美國,社群巨頭Snap也在今年1月砸下近50億新台幣,買下研究臉部偵測技術的新創公司AI Factory,藉以優化其類似於Deepfake的應用服務,這些都加速了Deepfake的發展。

他同時悲觀地預測,偵測Deepfake的AI技術將會輸給產製Deepfake的AI技術,人們必須找其他的方法來應付由Deepfake驅動的資訊戰。

值得注意的是,就在今年2月底,AI電腦視覺領域的權威、知名影像辨識演算法「YOLO」的開發者喬瑟夫・瑞德曼(Joseph Redmon)也宣布,自己將中止一切關於電腦視覺的研究,在AI圈造成不小的轟動。

瑞德曼說,他雖熱愛自己的研究,但他同時也對這些研究成果將會如何被拿來應用、以及後續延伸的道德議題感到不安。這似乎也暗示了,影像辨識、偵測甚至重建的AI深度學習模型的成熟度,已經使專家學者都無法忽視。

但一個權威退下陣來,不代表其他學者不會迎頭趕上。

既然AI技術的高速發展是阻擋不來的大勢,那它會對未來社會造成什麼影響?北科大互動設計系助理教授葛如鈞預測,在未來,每個人的臉跟聲音,都會成為相當重要的資產。

「我覺得人們會迎來一個真相非常寶貴的時代,」葛如鈞說,「因為別人可以很低的門檻,利用他人的臉和聲音做不好的事情。像是用在色情影片裡、被拿去開銀行帳戶,或者用來詐騙都有可能。」

與真相的距離被拉大,人們要如何適應?

面對自己的臉與聲音被盜用的風險,葛如鈞認為,未來可能會出現一種平台,專門讓人公開註冊自己的臉部數據。想要使用的,就經過合法授權程序來申請,否則就會開罰。透過類似版權的概念,藉以防堵未來「盜版人臉」猖獗的問題。

但他也表示,這樣的應用也可能發展出自己的一套商業模式。舉例來說,某些藝人或者網紅,可能只要授權自己的臉,就可以透過一個身形相似的替身,來幫他們出外景、主持節目。

聽起來令人難以接受嗎?葛如鈞指出,我們生活中本來就已經有「無修正的真相」以及「修正過的真相」之分。至少目前可以看到,大家對直播主用化妝及濾鏡效果做出的樣貌開始覺得稀鬆平常,逐漸接受這樣的「修正過的真相」。

而人們對「遭到微調、修正的真相」的接受程度,恐怕只會愈來愈寬。

Deepfake的技術成熟,對社會也不只有壞處。除了能夠優化VR裡的3D人物建模等,科技領域的推進與成長;在具體應用方面,近來就有印度政黨在一次選前影片中,利用Deepfake技術讓參選人用不同的方言說話。對於有超過20種官方語言的印度來說,可說是大大地幫候選人拉近了與選民的距離。

Deepfake並非洪水猛獸。但它的到來,勢必會拉高人們得到真相所需的門檻。

「你看網路上的Deepfake影片,下面總有許多網友留言說:『你做得太爛了,一看就知道是假的!』這其實是很危險的徵兆。」葛如鈞說。

「大家太相信自己的判斷力了。要能真的不上Deepfake的當,每個人都應該自帶一個防禦機制——也就是相信你自己絕對看不出真假,才有辦法抵禦。」

責任編輯:林美欣